diff --git a/README.md b/README.md

index e606db2..e409d56 100644

--- a/README.md

+++ b/README.md

@@ -111,7 +111,7 @@ python -m pip install -r requirements.txt

# (II-3)python -m pip install -r requirements.txt

```

-如果需要支持清华ChatGLM后端,需要额外安装更多依赖(不熟悉python、电脑配置不佳者,建议不要尝试):

+如果需要支持清华ChatGLM后端,需要额外安装更多依赖(前提条件:熟悉python + 电脑配置够强):

```sh

python -m pip install -r request_llm/requirements_chatglm.txt

```

@@ -133,22 +133,25 @@ python main.py

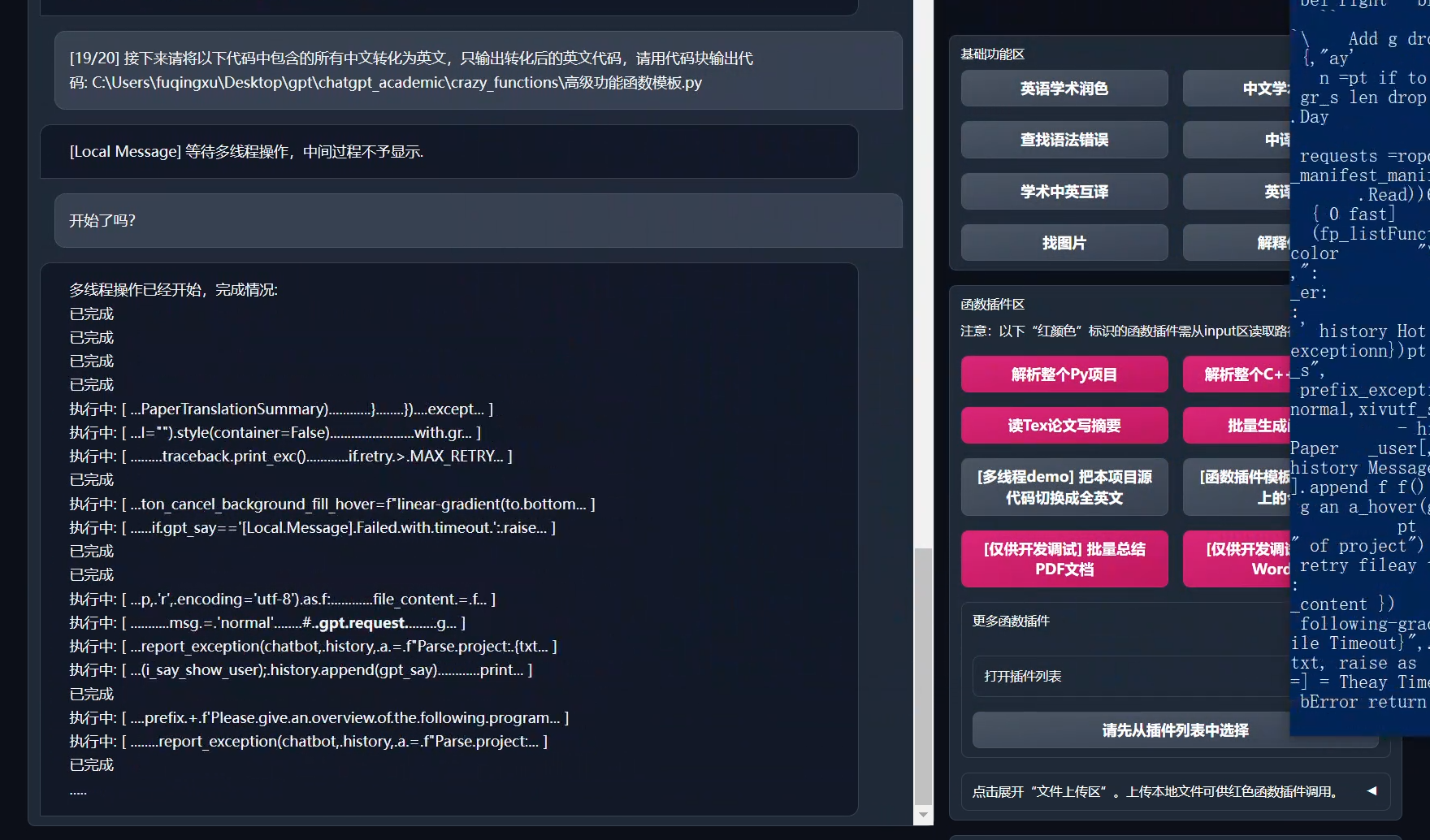

- 函数插件区下拉菜单中有更多功能可供选择

```

-## 安装-方法2:使用Docker (Linux)

+## 安装-方法2:使用Docker

1. 仅ChatGPT(推荐大多数人选择)

+

``` sh

# 下载项目

git clone https://github.com/binary-husky/chatgpt_academic.git

cd chatgpt_academic

-# 配置 海外Proxy 和 OpenAI API KEY

+# 配置 “海外Proxy”, “API_KEY” 以及 “WEB_PORT” (例如50923) 等

用任意文本编辑器编辑 config.py

# 安装

docker build -t gpt-academic .

-# 运行

+#(最后一步-选择1)在Linux环境下,用`--net=host`更方便快捷

docker run --rm -it --net=host gpt-academic

+#(最后一步-选择2)在macOS/windows环境下,只能用-p选项将容器上的端口(例如50923)暴露给主机上的端口

+docker run --rm -it -p 50923:50923 gpt-academic

```

-2. ChatGPT+ChatGLM(需要对docker熟悉 + 读懂Dockerfile + 电脑配置够强)

+2. ChatGPT+ChatGLM(需要对Docker熟悉 + 读懂Dockerfile + 电脑配置够强)

``` sh

# 修改Dockerfile

@@ -261,6 +264,14 @@ docker run --rm -it --net=host --gpus=all gpt-academic bash

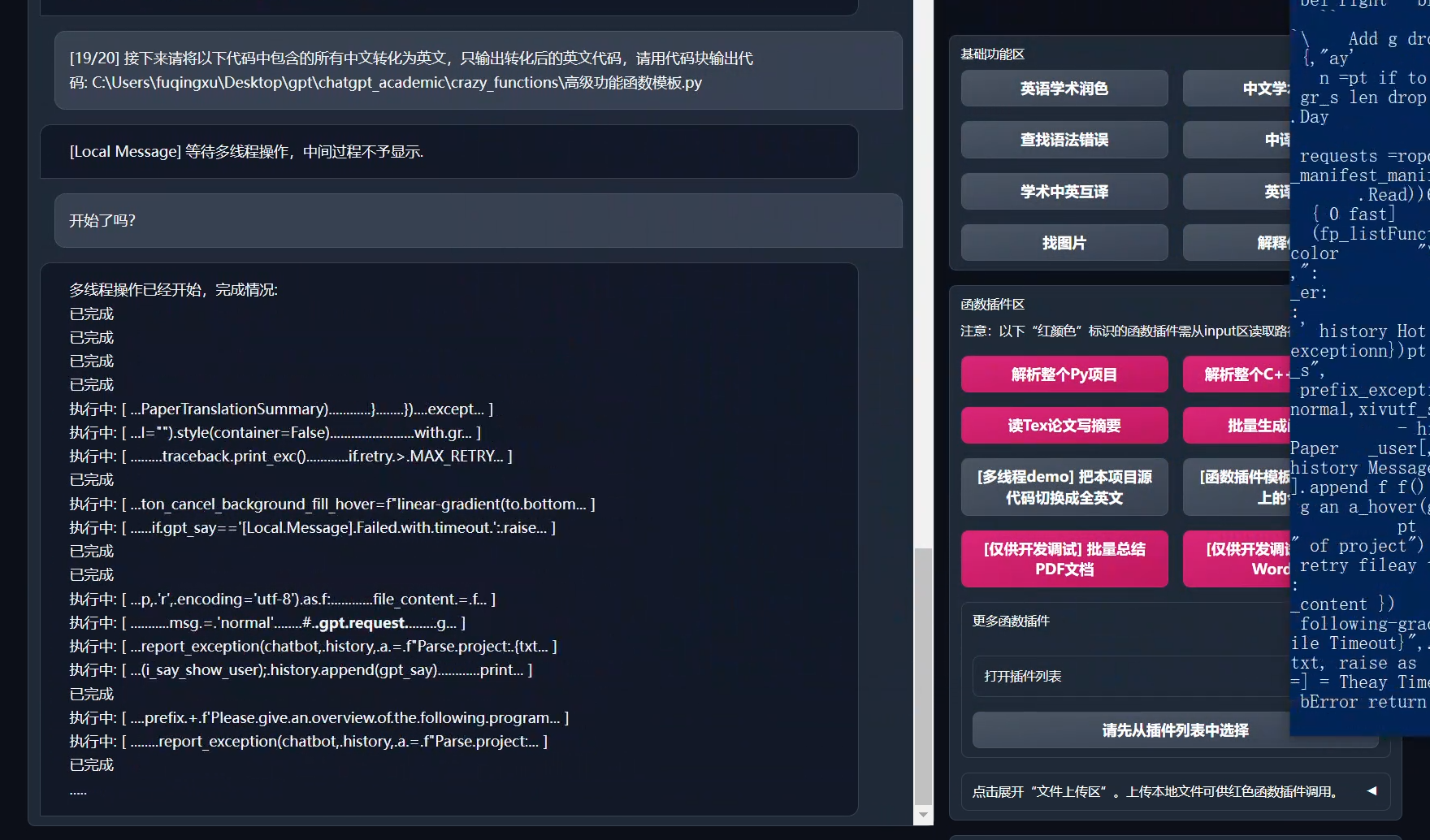

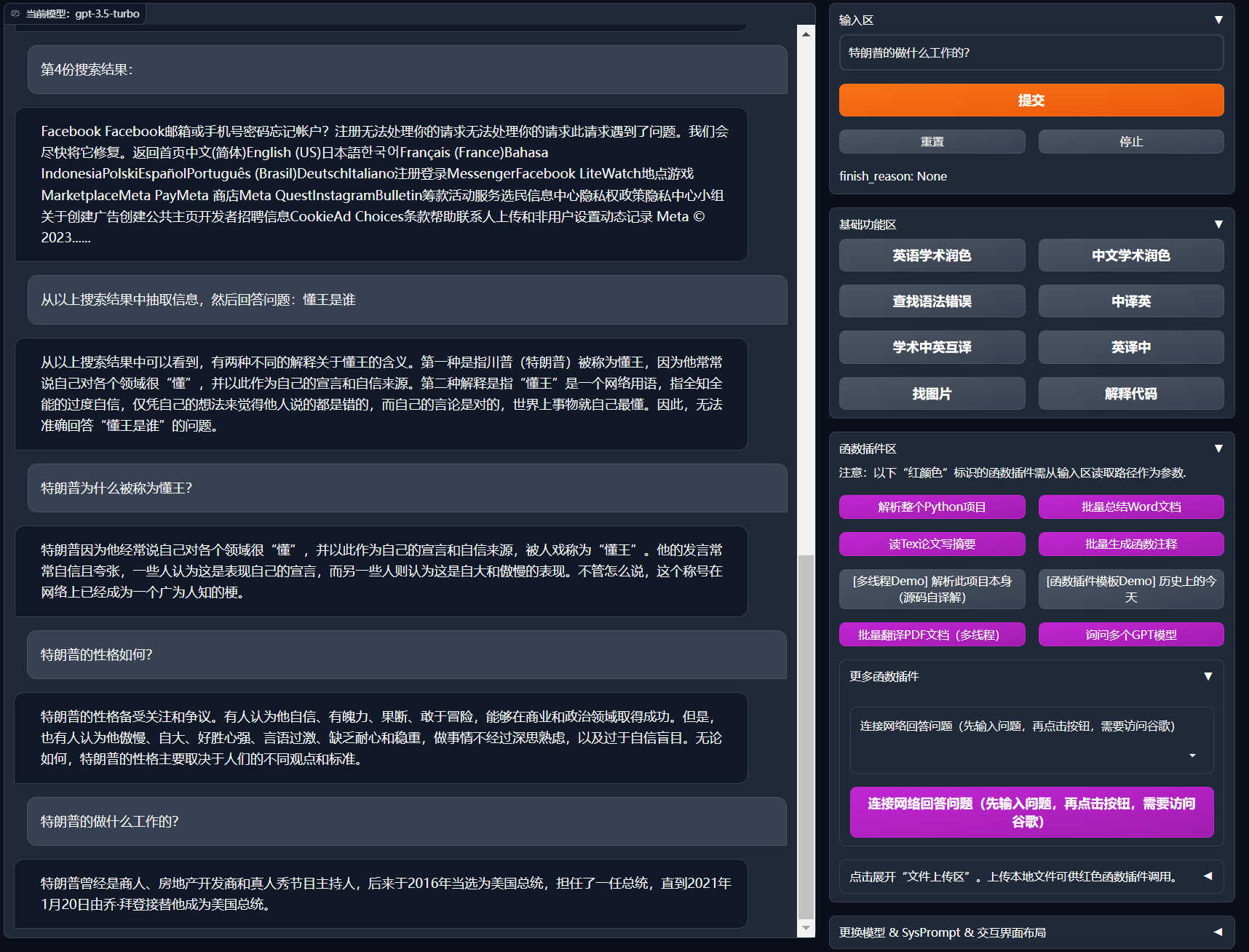

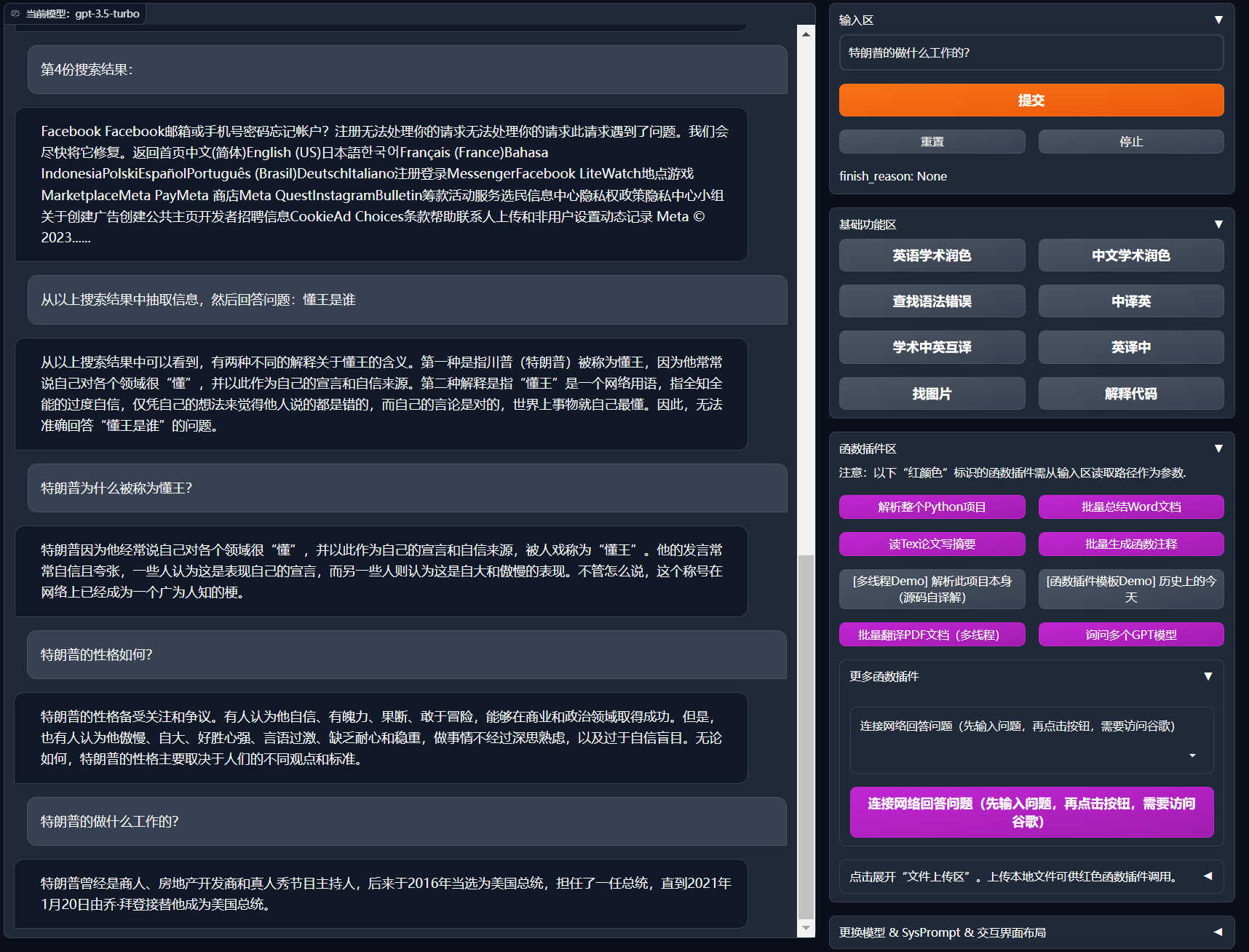

+8. 互联网在线信息综合

+

+

+8. 互联网在线信息综合

+

+

+

+

\n\n---\n\n'.join(return_string_collect)

+ res = '

\n\n---\n\n'.join(return_string_collect)

return res

diff --git a/request_llm/bridge_chatglm.py b/request_llm/bridge_chatglm.py

index 7af2835..8eef322 100644

--- a/request_llm/bridge_chatglm.py

+++ b/request_llm/bridge_chatglm.py

@@ -92,8 +92,8 @@ def predict_no_ui_long_connection(inputs, llm_kwargs, history=[], sys_prompt="",

# chatglm 没有 sys_prompt 接口,因此把prompt加入 history

history_feedin = []

+ history_feedin.append(["What can I do?", sys_prompt])

for i in range(len(history)//2):

- history_feedin.append(["What can I do?", sys_prompt] )

history_feedin.append([history[2*i], history[2*i+1]] )

watch_dog_patience = 5 # 看门狗 (watchdog) 的耐心, 设置5秒即可

@@ -131,10 +131,13 @@ def predict(inputs, llm_kwargs, plugin_kwargs, chatbot, history=[], system_promp

inputs = core_functional[additional_fn]["Prefix"] + inputs + core_functional[additional_fn]["Suffix"]

history_feedin = []

+ history_feedin.append(["What can I do?", system_prompt] )

for i in range(len(history)//2):

- history_feedin.append(["What can I do?", system_prompt] )

history_feedin.append([history[2*i], history[2*i+1]] )

for response in glm_handle.stream_chat(query=inputs, history=history_feedin, max_length=llm_kwargs['max_length'], top_p=llm_kwargs['top_p'], temperature=llm_kwargs['temperature']):

chatbot[-1] = (inputs, response)

- yield from update_ui(chatbot=chatbot, history=history)

\ No newline at end of file

+ yield from update_ui(chatbot=chatbot, history=history)

+

+ history.extend([inputs, response])

+ yield from update_ui(chatbot=chatbot, history=history)

\ No newline at end of file

diff --git a/request_llm/bridge_chatgpt.py b/request_llm/bridge_chatgpt.py

index 34c3ff6..c1a900b 100644

--- a/request_llm/bridge_chatgpt.py

+++ b/request_llm/bridge_chatgpt.py

@@ -21,7 +21,7 @@ import importlib

# config_private.py放自己的秘密如API和代理网址

# 读取时首先看是否存在私密的config_private配置文件(不受git管控),如果有,则覆盖原config文件

-from toolbox import get_conf, update_ui, is_any_api_key, select_api_key

+from toolbox import get_conf, update_ui, is_any_api_key, select_api_key, what_keys

proxies, API_KEY, TIMEOUT_SECONDS, MAX_RETRY = \

get_conf('proxies', 'API_KEY', 'TIMEOUT_SECONDS', 'MAX_RETRY')

@@ -118,7 +118,7 @@ def predict(inputs, llm_kwargs, plugin_kwargs, chatbot, history=[], system_promp

"""

if is_any_api_key(inputs):

chatbot._cookies['api_key'] = inputs

- chatbot.append(("输入已识别为openai的api_key", "api_key已导入"))

+ chatbot.append(("输入已识别为openai的api_key", what_keys(inputs)))

yield from update_ui(chatbot=chatbot, history=history, msg="api_key已导入") # 刷新界面

return

elif not is_any_api_key(chatbot._cookies['api_key']):

@@ -141,7 +141,7 @@ def predict(inputs, llm_kwargs, plugin_kwargs, chatbot, history=[], system_promp

try:

headers, payload = generate_payload(inputs, llm_kwargs, history, system_prompt, stream)

except RuntimeError as e:

- chatbot[-1] = (inputs, f"您提供的api-key不满足要求,不包含任何可用于{llm_kwargs['llm_model']}的api-key。")

+ chatbot[-1] = (inputs, f"您提供的api-key不满足要求,不包含任何可用于{llm_kwargs['llm_model']}的api-key。您可能选择了错误的模型或请求源。")

yield from update_ui(chatbot=chatbot, history=history, msg="api-key不满足要求") # 刷新界面

return

diff --git a/toolbox.py b/toolbox.py

index db3a2b7..2fd5da2 100644

--- a/toolbox.py

+++ b/toolbox.py

@@ -433,6 +433,19 @@ def is_any_api_key(key):

else:

return is_openai_api_key(key) or is_api2d_key(key)

+def what_keys(keys):

+ avail_key_list = {'OpenAI Key':0, "API2D Key":0}

+ key_list = keys.split(',')

+

+ for k in key_list:

+ if is_openai_api_key(k):

+ avail_key_list['OpenAI Key'] += 1

+

+ for k in key_list:

+ if is_api2d_key(k):

+ avail_key_list['API2D Key'] += 1

+

+ return f"检测到: OpenAI Key {avail_key_list['OpenAI Key']} 个,API2D Key {avail_key_list['API2D Key']} 个"

def select_api_key(keys, llm_model):

import random

@@ -448,7 +461,7 @@ def select_api_key(keys, llm_model):

if is_api2d_key(k): avail_key_list.append(k)

if len(avail_key_list) == 0:

- raise RuntimeError(f"您提供的api-key不满足要求,不包含任何可用于{llm_model}的api-key。")

+ raise RuntimeError(f"您提供的api-key不满足要求,不包含任何可用于{llm_model}的api-key。您可能选择了错误的模型或请求源。")

api_key = random.choice(avail_key_list) # 随机负载均衡

return api_key

diff --git a/version b/version

index bb462e2..b645825 100644

--- a/version

+++ b/version

@@ -1,5 +1,5 @@

{

- "version": 3.1,

+ "version": 3.15,

"show_feature": true,

- "new_feature": "添加支持清华ChatGLM和GPT-4 <-> 改进架构,支持与多个LLM模型同时对话 <-> 添加支持API2D(国内,可支持gpt4)<-> 支持多API-KEY负载均衡(并列填写,逗号分割) <-> 添加输入区文本清除按键"

+ "new_feature": "添加联网(Google)回答问题插件 <-> 修复ChatGLM上下文BUG <-> 添加支持清华ChatGLM和GPT-4 <-> 改进架构,支持与多个LLM模型同时对话 <-> 添加支持API2D(国内,可支持gpt4)"

}

+

+ +8. 互联网在线信息综合

+

+

+8. 互联网在线信息综合

+

+ +

+